VGG16-FP16

图像分类

FP16

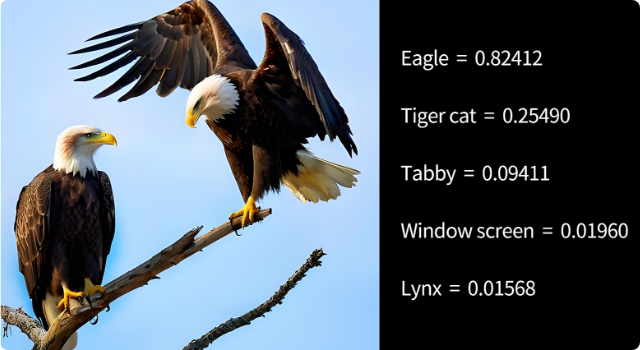

VGG16:图像分类

VGG16是牛津大学视觉几何组(Visual Geometry Group, VGG)在2014年提出的卷积神经网络模型。该模型以其深度和简单的网络结构设计而闻名。VGG16由16层网络组成,包括13个卷积层和3个全连接层。它采用小尺寸的3x3卷积核堆叠来增加网络深度,从而有效捕捉图像的局部特征,同时保持较小的计算量。VGG16在ImageNet数据集上的图像分类任务中表现优异,并成为许多后续模型的基础网络结构。尽管其参数量较大,但VGG16的结构简单且易于迁移到其他计算机视觉任务中。

源模型

- 输入尺寸: 224x224

- 参数量: 132.94M

- 模型大小: 527.8M

- 输出尺寸:1x1000

源模型仓库:VGG16

性能参考

设备

AI框架

数据精度

推理耗时

精确度损失

模型大小

模型转换

当用户对源模型进行过微调,需要重新进行模型转换。

用户可以自行参考以下两种方式完成模型转换:

使用 AIMO 完成模型转换:在右侧性能参考板块中点击模型转换参考查看模型转换步骤

使用高通 QNN 完成模型转换:请参考 Qualcomm QNN 文档

模型推理

Model Farm 所提供的模型性能基准测试以及示例代码皆基于阿加犀AidLite SDK 实现。

对于模型文件格式为 .bin 的模型,可以使用以下两种推理引擎完成模型在高通芯片上推理:

使用 APLUX AidLite 推理:详情请参考 APLUX AidLite 开发者文档

使用 Qualcomm QNN 推理:请参考 Qualcomm QNN 文档

推理示例代码

推理示例代码是基于 AidLite SDK 实现

点击模型 & 代码下载模型文件和推理代码包,文件结构如下

/model_farm_{model_name}_aidlite

|__ models # folder where model files are stored

|__ python # aidlite python model inference example

|__ cpp # aidlite cpp model inference example

|__ README.md

性能参考

设备

AI框架

数据精度

推理耗时

精确度损失

模型大小